在人工智能技術快速發展的今天,視覺與文本數據的融合成為了一項重要挑戰。傳統模型在處理結構化視覺文檔時存在諸多限制,影響了自動內容提取和理解能力。 IBM 近期發布的Granite-Vision-3.1-2B,正是為解決這一問題而設計的視覺語言模型。

隨著人工智能技術的不斷發展,視覺與文本數據的融合成為了一項複雜的挑戰。傳統的模型往往難以準確解析表格、圖表、信息圖和圖示等結構化視覺文檔,這一限制影響了自動內容提取和理解能力,進而影響了數據分析、信息檢索和決策等應用。面對這一需求,IBM 近期發布了Granite-Vision-3.1-2B,一款專為文檔理解設計的小型視覺語言模型。

Granite-Vision-3.1-2B 能夠從各種視覺格式中提取內容,包括表格、圖表和圖示。該模型基於精心挑選的數據集進行訓練,數據來源包括公共和合成源,能夠處理多種文檔相關的任務。作為Granite 大型語言模型的改進版,它將圖像和文本兩種模態進行了整合,從而提升了模型的解讀能力,適用於多種實際應用場景。

該模型由三個關鍵組件組成:首先是視覺編碼器,它使用SigLIP 高效處理和編碼視覺數據;其次是視覺語言連接器,這是一個帶有GELU 激活函數的雙層多層感知器(MLP) ,旨在連接視覺信息與文本信息;最後是大型語言模型,基於Granite-3.1-2B-Instruct,具備128k 的上下文長度,可以處理複雜和龐大的輸入。

在訓練過程中,Granite-Vision-3.1-2B 借鑒了LlaVA,並結合了多層編碼器的特性,以及在AnyRes 中更密集的網格分辨率。這些改進增強了模型理解詳細視覺內容的能力,使其能夠更準確地執行視覺文檔任務,例如分析表格和圖表、進行光學字符識別(OCR)以及回答基於文檔的查詢。

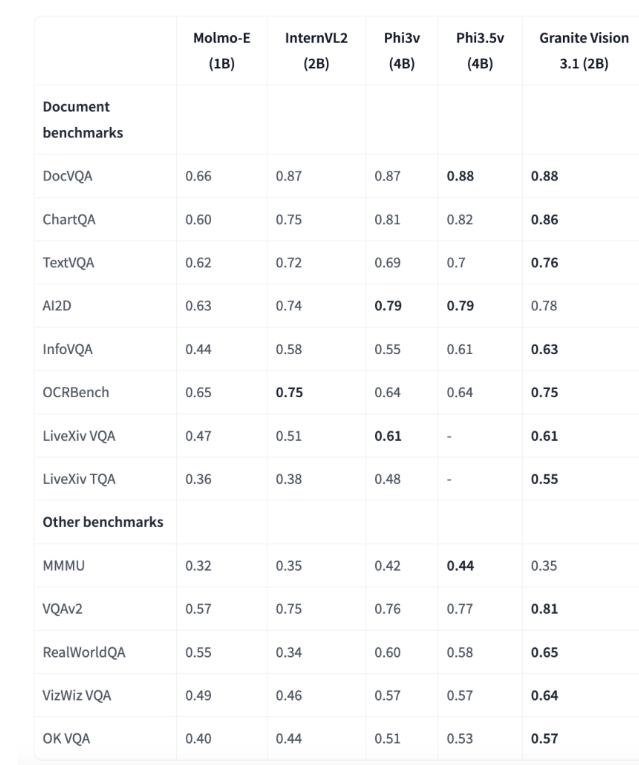

評估結果顯示,Granite-Vision-3.1-2B 在多個基準測試中表現優秀,尤其在文檔理解方面。在ChartQA 基準測試中,該模型的得分達到0.86,超越了其他參數在1B-4B 範圍內的模型。在TextVQA 基準測試中,得分為0.76,展現出在解析和回答圖像中嵌入的文本信息方面的強大能力。這些成果凸顯了該模型在企業應用中對精確視覺和文本數據處理的潛力。

IBM 的Granite-Vision-3.1-2B 代表了視覺語言模型的一次重要進步,提供了一個均衡的視覺文檔理解方案。其架構和訓練方法使其能夠高效地解析和分析複雜的視覺和文本數據。由於其對變換器和vLLM 的原生支持,該模型可以適應多種用例,並能在諸如Colab T4等雲環境中部署,為研究人員和專業人士提供了一種增強AI 驅動文檔處理能力的實用工具。

模型:https://huggingface.co/ibm-granite/granite-vision-3.1-2b-preview

劃重點:

Granite-Vision-3.1-2B 是IBM 推出的專為文檔理解設計的小型視覺語言模型,能夠處理多種視覺格式的內容提取。

模型由視覺編碼器、視覺語言連接器和大型語言模型三部分組成,提升了對複雜輸入的理解能力。

在多個基準測試中表現優異,特別是在文檔理解領域,展現出強大的企業應用潛力。

IBM 的Granite-Vision-3.1-2B 不僅提升了視覺與文本數據的融合能力,更為企業提供了強大的文檔處理工具,展現了AI 技術在實際應用中的巨大潛力。