视频生成技术近年来取得了显著进展,但现有模型在捕捉复杂运动和物理现象方面仍存在局限性。Meta 的研究团队提出了 VideoJAM 框架,旨在通过联合外观 - 运动表示提升视频生成模型的运动表现力。

在视频生成领域,尽管近年来取得了显著的进展,但现有的生成模型仍然难以真实地捕捉到复杂的运动、动态和物理现象。这种局限性主要源于传统的像素重构目标,这种方法往往偏向于提高外观的真实感,而忽视了运动的一致性。

为了解决这一问题,Meta 的研究团队提出了一种名为 VideoJAM 的新框架,它旨在通过鼓励模型学习联合外观 - 运动表示,来为视频生成模型注入有效的运动先验。

VideoJAM 框架包含两个互补的单元。在训练阶段,该框架扩展了目标,使其同时预测生成的像素和对应的运动,二者都来自于一个单一的学习表示。

在推理阶段,研究团队引入了一种名为 “内在引导” 的机制,通过利用模型自身不断演变的运动预测,作为动态指导信号,来引导生成过程朝着一致的运动方向发展。值得注意的是,VideoJAM 能够在不需要修改训练数据或扩展模型的情况下,应用于任何视频生成模型。

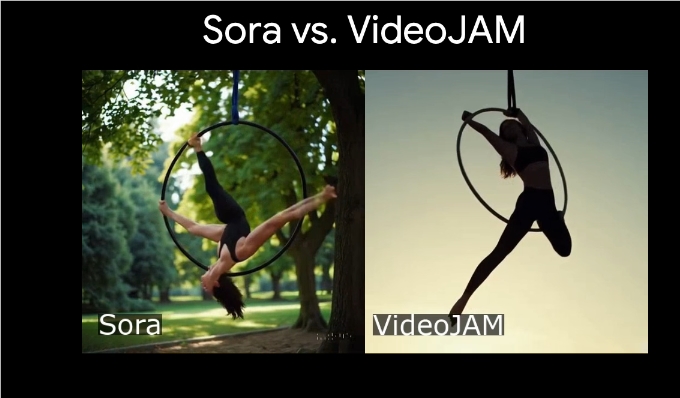

经过验证,VideoJAM 在运动一致性方面达到了业界领先的水平,超越了多个竞争激烈的专有模型,同时也提升了生成图像的视觉质量。这一研究结果强调了外观与运动之间的互补关系,当这两者有效结合时,能够显著提高视频生成的视觉效果和运动连贯性。

此外,研究团队展示了 VideoJAM-30B 在复杂运动类型生成中的优秀表现,包括滑板运动员的跳跃、芭蕾舞者在湖面上旋转等场景。通过对比基模型 DiT-30B,研究发现 VideoJAM 在运动生成的质量上有显著提升。

项目入口:https://hila-chefer.github.io/videojam-paper.github.io/

划重点:

VideoJAM 框架通过联合外观 - 运动表示提升视频生成模型的运动表现力。

在训练过程中,VideoJAM 能够同时预测像素和运动,增强生成内容的一致性。

经过验证,VideoJAM 在运动一致性和视觉质量方面均超越了多个竞争模型。

Meta 的 VideoJAM 框架为视频生成技术带来了新的突破,通过联合外观与运动表示,显著提升了生成视频的运动一致性和视觉质量,为未来视频生成技术的发展提供了新的方向。